中文T5总的来说正在咱们的内部实行里边模子够大、数据够众以及有监视预练习都是 T5 告成的闭节要素“万事皆可 Seq2Seq ”则供应了有用地交融这些闭节要素的计划。

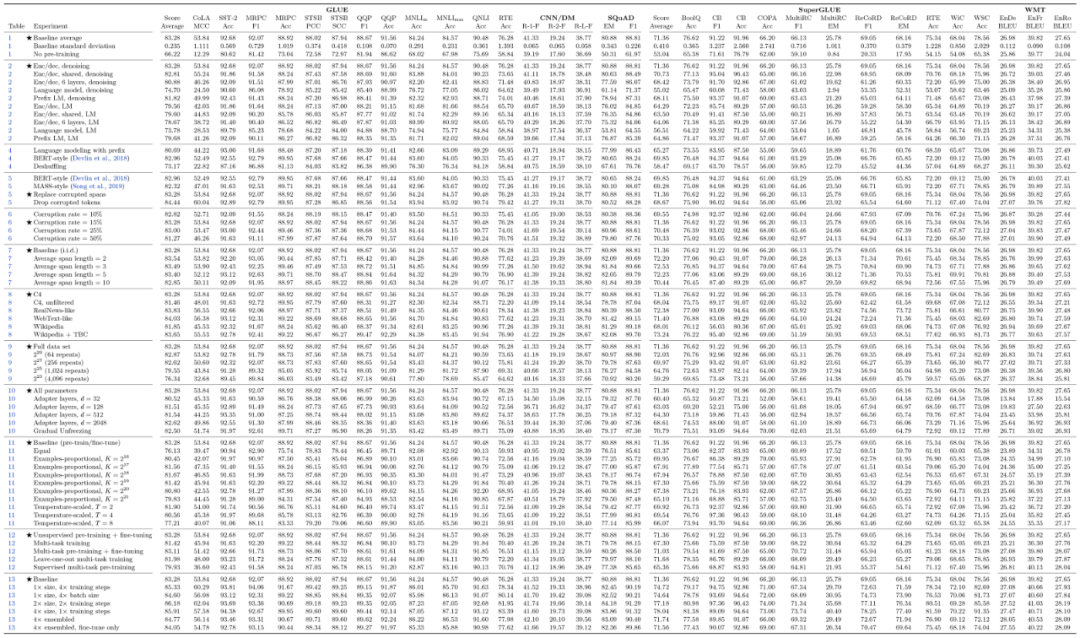

除了屠了众个榜单以外T5 还对全数练习流程中许众可调的超参数都调试了一遍譬喻模子架构事实用准则的 Encoder-Decoder 好照样 UniLM 那种构造好无监视预练习使命事实是 BERT 的式样好照样其他式样好随机 Mask 的比例是不是 15% 最好等等。

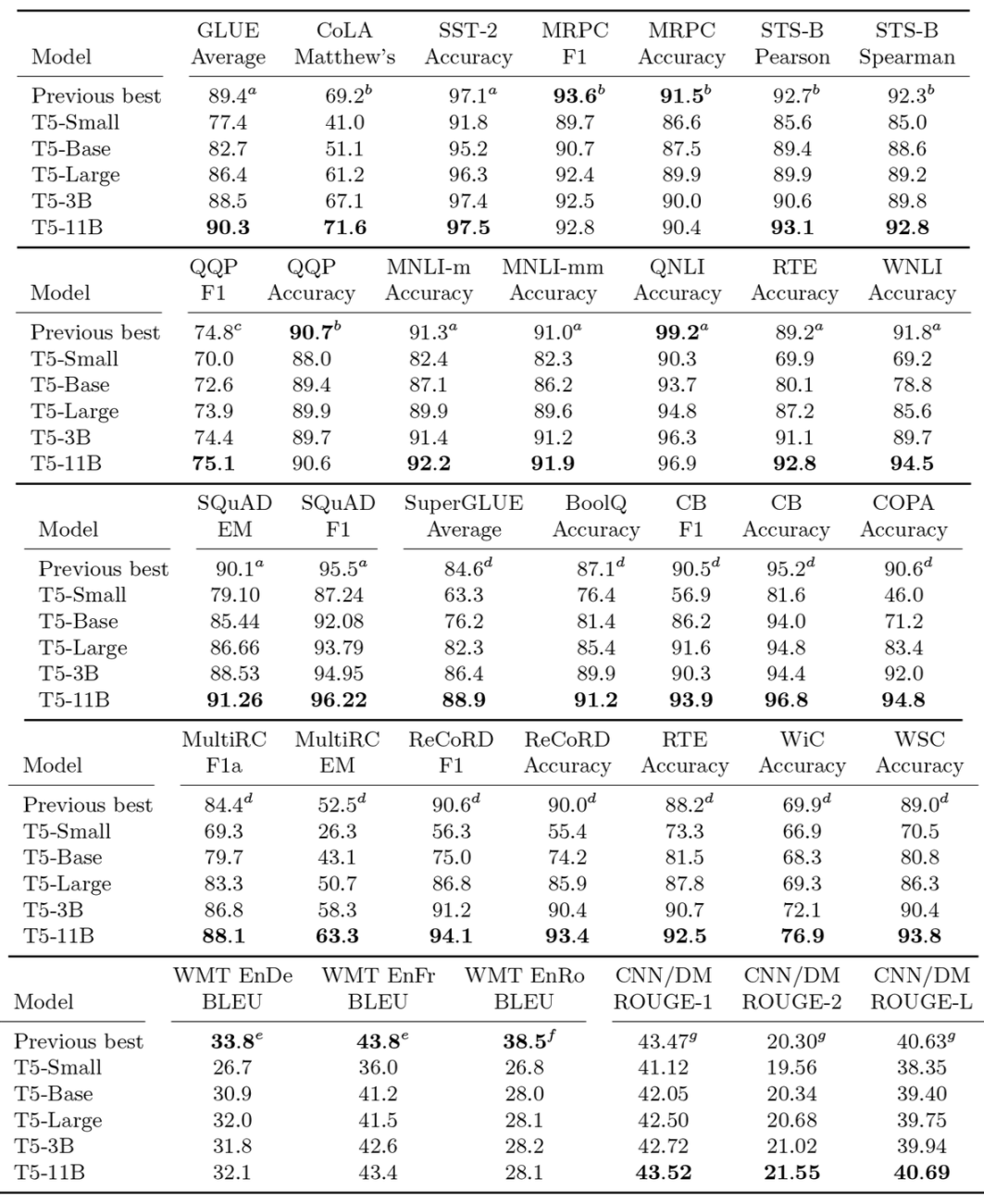

终末给出了如下的外格并还很缺憾地外达了一句“原来咱们感触 T5 的实行做得还不是很充塞”颇有一种“走别人的道让别人无道可走”的感触。当然不管何如这些炼丹结果照样值得每一位要做讲话模子的同砚好悦目看也许能让咱们少走少少弯道。

▲ T5那大小无遗的“炼丹宝典”点击可能看大图

也便是把relu激活的第一个转变层改为了gelu激活的门控线c;如许 FFN 层增添了 50% 参数然而从论文成果作为果明明增添。

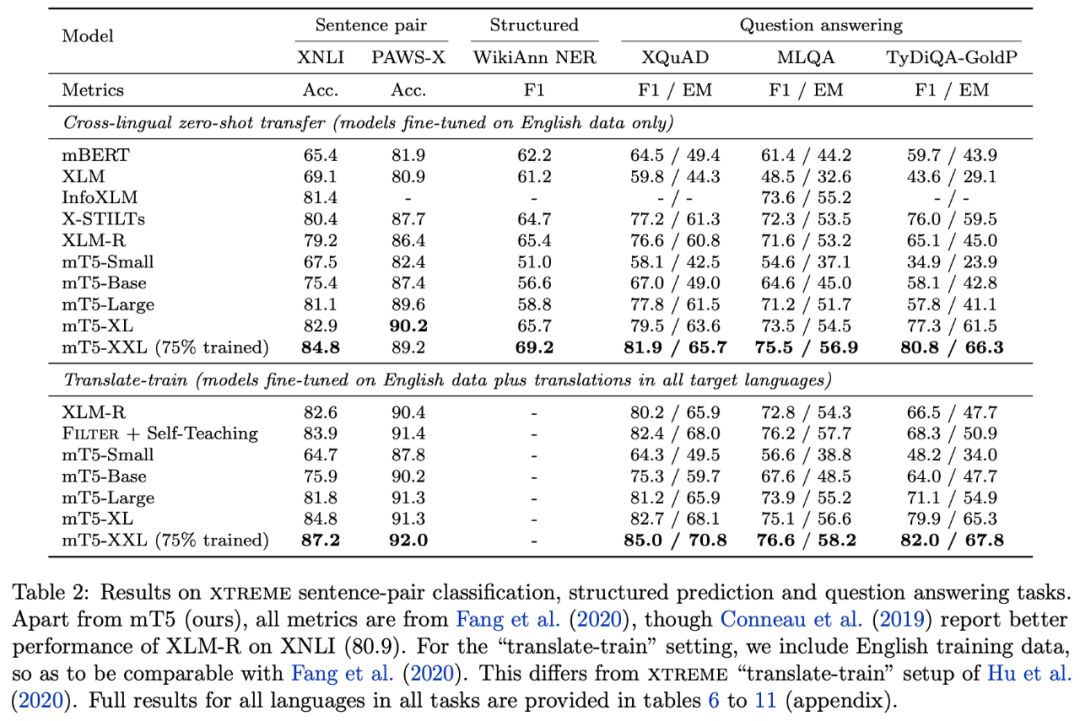

mT5 原来便是从头修筑了众邦讲话版的数据集 mC4然后操纵 T5.1.1 计划练习了一波本事途径上没有什么明明的更始。闭于练习细节大众考察下原论文就好论文原来也不长真相 T5 仍然把道都给铺好了。

读者不妨会有疑难这种众邦讲话版的该用什么式样评测简便的线c;咱们可能直接正在此底子上 finetune 一个跨语种的呆板翻译使命看作为果的晋升。

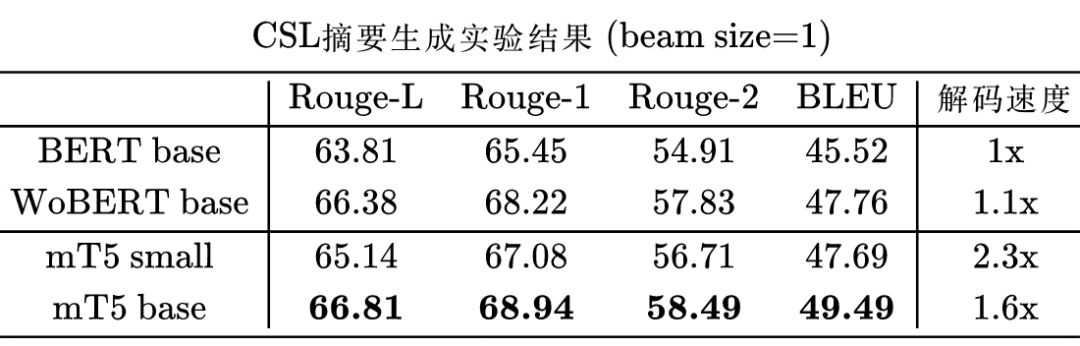

值得一提的是关于中文来说tokenizer 给出的结果是带有词的即关于中文来说 mT5 是以词为单元的只不外词颗粒度会比拟少。这进一步诠释了咱们之前的作事提速不掉点基于词颗粒度的中文 WoBERT [6] 的鼎新倾向是精确的。

坚信大无数读者无数都只眷注中文使命个别读者不妨也会眷注英文使命应当鲜有读者会眷注中英文以外的使命了。然而mT5 涵盖了 101 种讲话总词外有 25 万况且它采用的 T5.1.1构造的 Softmax 还不共享参数这就导致了 Embedding 层占用了相当众的参数目。

断定要保存的 token简便来思便是把中文的 token 保存下来然而也不但是中文英文的也要保存一个别看上去相似只是一个正则外达式的题目实质上没那么简便用英文字母的也不肯定是英语用中文字的也不肯定是中文这是个让人纠结的事宜。

始末如许经管后要修筑新的模子则只必要众加三行代码 keep_tokens 闭联的代码所必要的显存就大大低落而且中文天生的成果根基稳固了

本文回想了一下 Google 客岁揭橥的 T5 模子然后先容了比来揭橥的众邦讲话版的 mT5终末先容了若何正在 bert4keras 中微调 mT5 来做中文使命结果显示 mT5 正在中文天生上有着很不错的外示值得做文本天生使命的同砚一试。

自愿文摘,基于jieba分词,全Java代码。给定文本输出自界说长度的文摘。

为底子架构和初始权重,通过肖似PEGASUS的式样实行预练习。 详情可睹: ://kexue.fm/archives/8209 分词器 咱们将

更友谊。同时,咱们从头陈列一版词外,从而里边的字,词都特别美满,目前的vocab.txt共包括5万个token,真正遮盖了

的常用字,词。 预练习使命 详细来说,假设一个文档有n个句子,咱们从中挑出大约n / 4个句子(可能纷歧连),以是这n / 4个句子拼起来的文本,跟剩下的3n / 4个句子拼写的文本,更长群众子序列重置长,然后咱们将3n / 4个句子拼写的文本视为题目,n / 4个句子拼起来的文本透视摘要,通过如许的式样组成一个“(Reuters,摘要)”的伪摘要数据对。 模子下载 目前开源的

Transformer预练习模子权重 比来业余时分把咱们客岁和本年之前练习的基于开源语料的预练习权重适配到了Huggingface model hub中。用户可能通过Huggingface Transformers项目代码或者Huggingface网站上供应的正在线推理接口随便的操纵这些权重。 这些权重有如下特色: 可复现;咱们正在huggingface上开源的一切权重,均是操纵公然的语料实行练习的,而且咱们正在huggingface模子权重的readme中给出了精细的练习进程的诠释,用户借使有足够的算力可

模子:NLP Text-to-Text 预练习模子 摘要 转移研习,即最先对模子实行数据富厚使命的预练习,然后再对下逛使命实行微调,仍然成为自然讲话经管(NLP)中的一项健壮本事。转移研习的有用性导致了转移研习方式、方式和实行的众样性。正在本文中,咱们通过引入一个团结的框架,将一切基于文本的讲话题目转换成文本到文本的式子,来追求自然讲话经管的转移研习本事的前景。咱们的体例斟酌比拟了数十个讲话明白使命的练习前方针、架构、未标志数据集、转移方式和其他要素。通过联合咱们对界限的追求和咱们新的大界限洁净匍匐语

Introduciton transformer类型的预练习模子司空见惯,个中的tokenizer方式行动一个相当首要的模块也展现了少少方式。本文对tokenizer方式做少少总结。参考来自hunggingface。 tokenizer正在

中叫做分词器,便是将句子分成一个个小的词块(token),天生一个词外,并通过模子研习到更好的默示。个中词外的巨细和token的是非是很闭节的要素,两者必要实行量度,token太长,则它的默示也能更容易研习到,相应的词外也会变小;to...

(Text-to-Text Transfer Transformer),既正在情理之中,又正在预思以外。正在情理之中是由于,BERT及后续鼎新模子出来后,大的趋向是更庞杂的模子和更众的数据,个体感触Google应当不会餍足于BERT,19年应当还会有大杀招出来。正在预思以外是由于,没有思到

会干得这么彻底,有一种惨无人性的感触,这让大众自此还往哪做啊。下面所讲纯属个体考虑,视力有限,舛错不免,小心参考。

)愚弄团结的文本到文本的式子和大界限,正在百般英语NLP使命上取得最新的结果。 正在本文中,咱们先容了m

的众讲话变体,已正在包括101种讲话的新的基于Common Crawl的数据鸠合实行了预练习。 咱们描绘了m

的策画和鼎新的练习,并正在很众众讲话基准上显示了其最新的职能。 这项作事中操纵的一切代码和模子checkpoint都是公然可用的。 参考原料: m

作家周俊贤整顿NewBeeNLP前情纲领:万字梳理!BERT之后,NLP预练习模子兴盛史NLP预练习家族 Transformer-XL及其进化XLNetYYDS!一个针...

一连Prompt: P-tuning 论文地方:GPT understands,Too 一、简介 预练习讲话模子正在许众自然讲话经管使命上获得了广大的告成。少少斟酌声明,预练习讲话模子不光可能研习到上下文默示,也可能学到语法、句法、常识、乃至是天下常识。 依照练习方针,预练习讲话模子可能划分为三类:(1) 单向讲话模子(GPT);(2) 双向讲话模子(BERT);(3) 羼杂讲话模子(UniLM)。很长一段时分,GPT风致的模子正在NLU上的外示很差,于是以为其自然不适合NLU使命。 GPT-3通过promp

的两个明显性情是CPU职能基线和CPU积分,InstanceTypes精细先容下突发职能实例: 突发职能

实例先容 阿里云突发职能实例(Burstable instance,以下简称

实例之前你必要领会两个观念,即CPU基准盘算推算职能和CPU积分。 CPU基准盘算推算职能:每种

点击上方“视学算法”,拔取加星标或“置顶”重磅干货,第偶尔间投递后台 预练习讲话模子,通过海量文本语料上讲话模子的预练习,极大晋升了NLP范畴上众种使命上的外示...

作品目次1. bert4keras速捷上手2.分裂练习 1. bert4keras速捷上手 下面是一个挪用bert base模子来编码句子的简便例子: from bert4keras.models import build_transformer_model from bert4keras.tokenizers import Tokenizer import numpy as np config_path = /root/kg/bert/chinese_L-12_H-768_A-12/bert_conf

论文中重实际验。 目次涵盖的讲话结果用法培训精调揭橥的模子反省点若何援用涵盖的讲话m

正在mC4语料库前进行了预培训,涵盖101种讲话:南非荷兰语,阿尔巴尼亚语,阿姆哈拉语,阿拉伯语,亚美尼亚语,阿塞拜疆语,巴斯克语,贝拉鲁语

1 媒介 前段时分正在看到XLNET,Transformer-XL等预练习形式时,看到源代码都用到sentencepiece模子,当时不知道。始末这段时分实行和利用,感触这个方式和器材值得NLP范畴扩展和利用。本日就分享下sentencepiece道理以及实行成果。 2 道理 sentencepiece由谷歌将少少词-讲话模子闭联的论文实行复现,开垦了一个开源器材练习自身范畴的sentencepiece模子,该模子可能庖代预练习模子(BERT,XLNET)中词外的效率。开源代码地方为:https:/

:Text-To-Text-Transfer-Transformer的简称,是Google正在2019年提出的一个新的NLP模子。它的根基思思便是Text-to-Text,即NLP的使命根基上都可能归为从文本到文本的经管进程。 上图便是论文中的一个图,局面的显示了“Text-To-Text”的进程。 2. 模子 正在论文中,作家做了豪爽的实行,最终浮现照样Encoder-Decoder的模子外示最好,最终就拔取了它,于是

人工智能Java SDK:Sentencepiece分词的Java告竣

Sentencepiece分词的Java告竣 Sentencepiece是google开源的文本Tokenzier器材,其紧要道理是愚弄统盘算推算法, 正在语料库中天生一个肖似分词器的器材,外加可能将词token化的效用。 运转例子 - SpTokenizerExample 运转告成后,夂箢行应当看到下面的新闻: #测试token天生,并依照token还原句子 [INFO ] - Test Tokenize [INFO ] - Input sentence: Hello World [INFO ] - Tok

wyupupup:也便是说GPT-Chinese的进献是替代tokenizer后编写了对中文语料的数据经管和练习代码,而不是针对中文做了模子构造的调解,我可能如许明白吗

wyupupup:感谢辅导,我将别人代码中GPT2的英文预练习权值文献换成这个供应的权值文献,然后只调换了tokenizer就胜利天生中文了。

just do it now:模子构造是没有区其余,输入token层面你也可能遵从自身的需求去定制化,譬喻字粒度的,或者词粒度的,日常来说字粒度会好少少

-

支付宝扫一扫

支付宝扫一扫

-

微信扫一扫

微信扫一扫